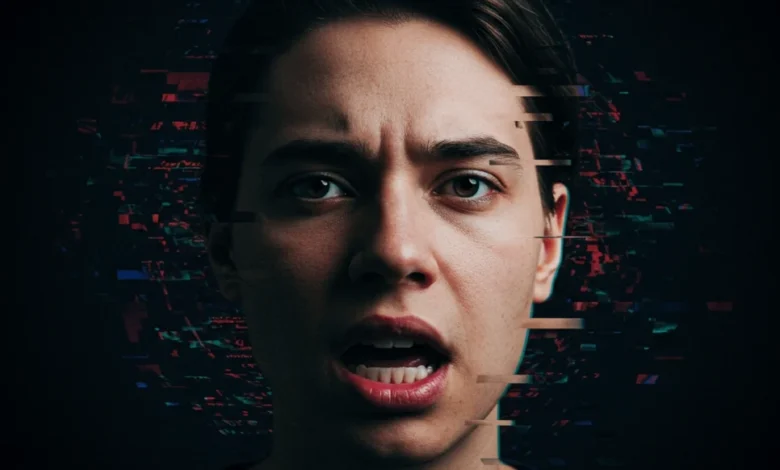

Deepfakes personales: del entretenimiento al fraude y más allá

Los deepfakes dejaron de ser un entretenimiento digital para convertirse en una amenaza concreta. Audio y video manipulados pueden ser usados para fraudes personalizados, y la confianza que depositamos en la voz y la imagen de otros está en juego.

Durante años, los deepfakes fueron un fenómeno de entretenimiento y curiosidad tecnológica. Clips virales en redes sociales, rostros de celebridades superpuestos en escenas ficticias y videos humorísticos con políticos diciendo cosas imposibles son algunos ejemplos. Hoy se utiliza este recurso para realizar fraudes personalizados por parte de cualquier persona con conocimientos técnicos básicos. Es el momento de precisar cómo funcionan y cómo podemos protegernos de ellos.

La transformación de los deepfakes de elementos de la cultura meme a la estafa digital es más que un cambio de contexto; es un síntoma de la democratización de herramientas de inteligencia artificial capaces de manipular audio y video. Esta accesibilidad se transformó en una vía de ataque contra las personas a través de un nuevo formato de fraude: ya no se busca atacar instituciones financieras con malware sofisticado, sino explotar la confianza básica que sentimos los humanos cuando reconocemos la voz de un familiar o vemos el rostro de un colega.

De la innovación abierta al fraude cotidiano

La transición de los deepfakes hacia el fraude está directamente relacionada con la aparición de modelos de código abierto y plataformas accesibles que redujeron el costo y la complejidad técnica de la generación de falsificaciones audiovisuales. Lo que antes requería hardware especializado, datasets elaborados y habilidades de programación avanzadas. hoy puede lograrse con aplicaciones instaladas en un teléfono.

Herramientas como DeepFaceLab (un framework de código abierto para intercambiar caras), RVC (Retrieval-based Voice Conversion – especializado en clonar voces) o Wav2Lip (sincroniza labios con audio) se encuentran disponibles en repositorios públicos y pueden entrenarse con datos mínimos para replicar expresiones faciales o voces con razonable precisión (https://doi.org/10.48550/arXiv.2404.13146). Esto significa que la barrera de entrada para crear un clon digital de alguien, ya sea para un experimento artístico o para un fraude, es mínima.

Esto plantea un cambio en el modelo de las amenazas informáticas. Según el informe IOCTA 2025 de Europol, los cibercriminales están incorporando técnicas basadas en deepfakes en esquemas de fraude financiero, extorsión y manipulación psicológica, señalando que la línea que separa el cibercrimen técnico del engaño interpersonal se ha difuminado (https://www.europol.europa.eu/cms/sites/default/files/documents/Steal-deal-repeat-IOCTA_2025.pdf).

Voice cloning

Uno de los ejemplos de esta transición son los fraudes basados en clonación de voz, que ya se han documentado en plataformas de mensajería ampliamente usadas en América Latina, como WhatsApp y Telegram. La dinámica es simple: los atacantes recopilan fragmentos de audio de una víctima, a menudo tomados de notas de voz enviadas en chats grupales o incluso de publicaciones en redes sociales, y entrenan modelos de síntesis que pueden reproducir el timbre y las inflexiones de esa persona.

Con apenas unos minutos de material, un sistema basado en voice cloning puede generar frases completas que suenan indistinguibles de la voz original. El resultado: llamadas de emergencia en las que un supuesto hijo pide dinero urgente, o mensajes de voz en los que un supuesto colega solicita información sensible. Estos ataques ya no son especulativos: el informe IOCTA 2025 documenta incidentes en los que esta técnica se utilizó con éxito para defraudar tanto a individuos como a empresas pequeñas (https://www.europol.europa.eu/publications-events/main-reports/iocta-report).

Lo preocupante es que la víctima no necesita ser una figura pública con abundante material audiovisual en línea; basta con que cualquier persona tenga unos pocos segundos de audio expuestos de un chat privado para pasar a ser una víctima potencial.

Phishing visual y soporte técnico enmascarado

Los deepfakes no se limitan al audio. La generación de video sintético, particularmente a través de la técnica de lip-syncing, permite que un atacante cree transmisiones falsas en las que una persona parece estar diciendo palabras que nunca pronunció.

Este fenómeno ha dado lugar a un nuevo tipo de phishing visual: la aparición de supuestos agentes de soporte técnico en videollamadas que en realidad son avatares generados por IA. Investigadores de DARPA, en el marco del programa Media Forensics (MediFor), han demostrado que es posible manipular en tiempo real el rostro de un interlocutor para que parezca otro, lo cual abre la puerta a escenarios en los que un estafador podría hacerse pasar por un empleado legítimo de un banco o de una empresa de software durante una videoconferencia (https://www.darpa.mil/program/media-forensics).

Experimentos controlados han mostrado que las víctimas tienen una capacidad limitada para detectar inconsistencias visuales en estas falsificaciones. Incluso ante falsificaciones obvias, como las que muestran desincronización de labios o sombras poco realistas, la mayoría de los usuarios tiende a confiar en la coherencia general de la escena. Este sesgo de percepción convierte a los deepfakes en armas psicológicas de gran eficacia, pues no buscan engañar a un algoritmo, sino a la mente de las personas.

El frente de la verificación forense

Si esta amenaza se ha vuelto común, la defensa también ha comenzado a democratizarse. Instituciones como el NIST (National Institute of Standards and Technology) llevan varios años evaluando sistemas capaces de detectar manipulaciones audiovisuales mediante el análisis de patterns estadísticos y artefactos digitales. En enero de 2025 se publicó un informe titulado «Guardians of Forensic Evidence: Evaluating Analytic Systems Against AI-Generated Deepfakes», en el que se documentan pruebas a diferentes herramientas de detección, evaluando su eficacia en escenarios de fraude real (https://www.nist.gov/publications/guardians-forensic-evidence-evaluating-analytic-systems-against-ai-generated-deepfakes).

Iniciativas como OpenMFC (Open Media Forensics Challenge) han creado plataformas accesibles para que investigadores, empresas e incluso usuarios individuales puedan probar audios y videos en sistemas de análisis forense abiertos (https://www.nist.gov/itl/iad/mig/open-media-forensics-challenge). El objetivo de esta contramedida no es solo mejorar la precisión de los algoritmos, sino generar una cultura de verificación que ponga herramientas forenses al alcance de cualquiera, del mismo modo que los antivirus se popularizaron en los años noventa.

Un estudio publicado en abril de 2024 presentó la versión 2.0 de la plataforma DeepFake-O-Meter, diseñada para ofrecer a usuarios comunes la capacidad de cargar archivos y recibir diagnósticos sobre su posible manipulación (https://www.sciencedirect.com/science/article/pii/S240584402500653X). Aunque estas herramientas no son infalibles, representan un esfuerzo concreto para equilibrar el terreno de juego: la misma accesibilidad que permite a los atacantes generar falsificaciones, ya está disponible para que las víctimas potenciales puedan detectarlas.

El equilibrio entre verosimilitud y confianza

El verdadero peligro de los deepfakes no radica únicamente en su capacidad técnica, sino en el deterioro progresivo que producen en la confianza sobre lo que sea digital. Si cada llamada de voz puede ser sospechosa y cada videollamada puede estar adulterada, la consecuencia es un estado de sospecha permanente que afecta no solo a las víctimas directas de fraude, sino a la sociedad en su conjunto.

Esta dinámica fue estudiada desde la perspectiva sociotécnica por el Oxford Internet Institute, que advierte que el fenómeno podría producir un “colapso de la autenticidad digital”, en el que ninguna prueba audiovisual es suficiente sin un mecanismo de verificación independiente. En este escenario, la validez de la evidencia ya no depende del contenido perceptible, sino de características de ciberseguridad como la trazabilidad criptográfica y los sellos de código que certifiquen su origen (https://academic.oup.com/cybersecurity/article/10/1/tyae008/7631158).

El dilema es que la solución tecnológica, que consiste en insertar marcas digitales o sistemas de autenticación continua, siempre va un paso detrás de la creatividad de los cibercriminales. Mientras tanto, las personas quedamos atrapadas en una carrera asimétrica: un ecosistema donde el fraude personal basado en IA se convierte en un fenómeno tan común como el spam o el phishing lo fueron en décadas anteriores.

Conclusión: lo personal como campo de batalla

Los deepfakes dejaron de ser un espectáculo de laboratorio o un recurso para informáticos curiosos. Hoy forman parte del arsenal cotidiano de los cibercriminales, que ya no necesitan irrumpir en bases de datos corporativas ni desplegar malware sofisticado para obtener beneficios. Les basta con explotar una de las características más humanas y vulnerables: la confianza que depositamos en la voz o en la imagen de otra persona.

Frente a esto, la única salida es una combinación de avances técnicos en detección, educación digital masiva y marcos regulatorios que reconozcan el daño que estas falsificaciones pueden infligir en la vida diaria. El riesgo ya no es solo macroeconómico o institucional; es personal, íntimo y ubicuo.

Los próximos años definirán si debemos construir una cultura digital en la que cada clip audiovisual deba ser acompañado de un sello de autenticidad verificable, o convivir con el hecho de que cada voz y cada rostro puedan ser una mentira verosímil generada por una máquina.

Leer mas

- VerificAudio: la herramienta clave en la lucha contra los deepfakes de audio

- “Deepfakes”: La nueva frontera del delito financiero y cómo los bancos pueden protegerse

- Vacantes remotas y los deepfakes: cómo las empresas pueden evitar la contratación de postulantes ultrafalsos