Gigantes tecnológicos apuestan al ecosistema abierto de AMD para escalar la inteligencia artificial

En su evento Advancing AI, AMD consolidó su propuesta de un ecosistema abierto para inteligencia artificial, respaldado por gigantes como Meta, Oracle, Microsoft y Red Hat. Desde nuevas plataformas de hardware hasta alianzas estratégicas, la compañía mostró cómo sus soluciones están impulsando el entrenamiento, la inferencia y el despliegue de modelos de IA de próxima generación.

Durante el evento Advancing AI en San José, California, AMD no solo presentó innovaciones en hardware y software para inteligencia artificial, como el Helios AI Rack y la plataforma ROCm 7, sino que también demostró cómo su ecosistema está siendo adoptado por los principales actores del sector tecnológico. En una sesión enfocada en alianzas estratégicas, destacados socios tecnológicos compartieron cómo están utilizando soluciones AMD para entrenar y ejecutar modelos de IA de última generación, demostrando el crecimiento del ecosistema abierto impulsado por la compañía.

Meta: inferencia de Llama 3 y 4 con AMD Instinct

Meta fue una de las protagonistas de este panel de aliados. La empresa detalló cómo ha integrado múltiples generaciones de GPUs Instinct y CPUs EPYC de AMD en su infraestructura de centros de datos. En particular, resaltaron el despliegue a gran escala del acelerador MI300X, que actualmente potencia las tareas de inferencia de los modelos Llama 3 y Llama 4. Además, Meta confirmó su compromiso de colaboración a futuro, incluyendo planes para adoptar las nuevas GPUs MI350 y MI400 a medida que avanza el roadmap conjunto con AMD.

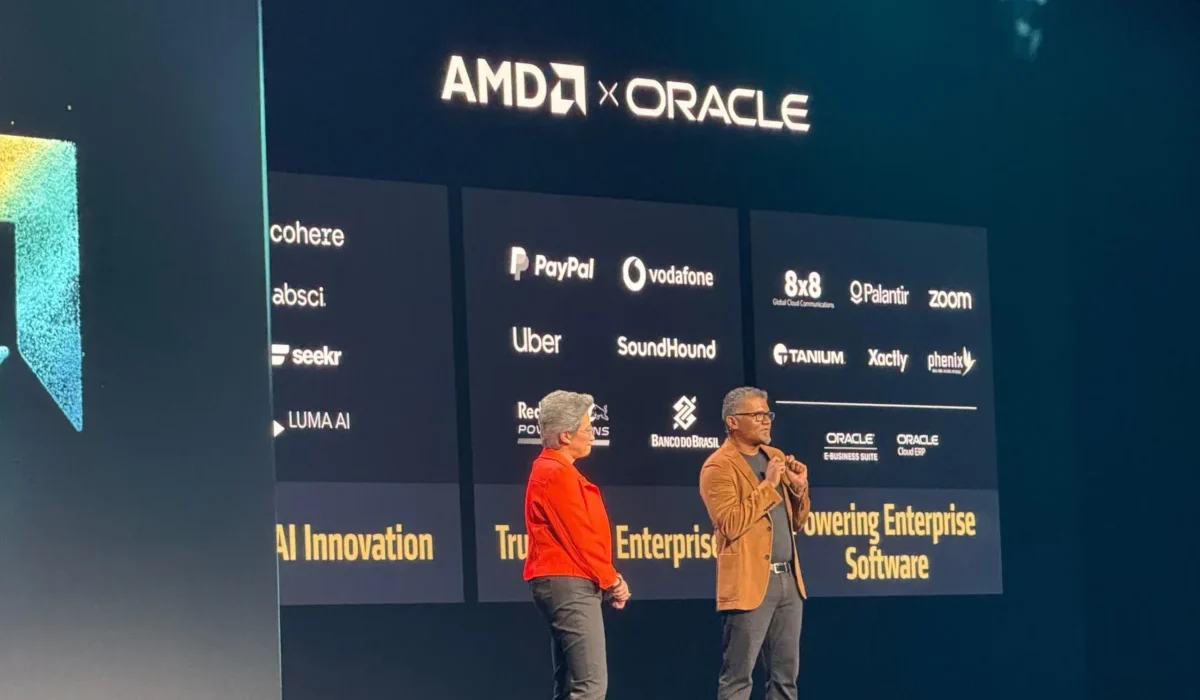

Oracle Cloud Infrastructure: IA a escala zetta

Oracle también tomó la palabra y reveló que fue uno de los primeros en adoptar la nueva infraestructura de IA a escala de rack desarrollada por AMD, equipada con GPUs MI355X. Según explicaron, Oracle Cloud Infrastructure (OCI) utiliza tanto CPUs como GPUs de AMD para ofrecer un rendimiento equilibrado y escalable en sus clústeres de inteligencia artificial. De hecho, anunciaron una ambiciosa oferta de clústeres de IA con capacidad zettascale, impulsados por hasta 131.072 GPUs MI355X, pensados para que sus clientes puedan construir, entrenar e inferir modelos de IA a gran escala.

Microsoft y Cohere: despliegues productivos con Instinct MI300X

Por su parte, Microsoft anunció que ya está utilizando los aceleradores Instinct MI300X para ejecutar tanto modelos propietarios como de código abierto en producción dentro de su nube Azure. Esta implementación refuerza la visión de AMD sobre la viabilidad de un ecosistema abierto, robusto y escalable.

A su vez, la empresa canadiense Cohere, especializada en modelos fundacionales para empresas, compartió que sus modelos Command se están ejecutando sobre GPUs MI300X. La compañía destacó el alto rendimiento, la eficiencia y la privacidad de datos como elementos clave para elegir esta plataforma en entornos empresariales exigentes.

HUMAIN y Red Hat: IA abierta, resiliente y lista para producción

HUMAIN, un nuevo actor en infraestructura de IA, anunció un acuerdo con AMD para construir soluciones abiertas, escalables y rentables basadas en todo el espectro de plataformas de cómputo que AMD ofrece. Esta alianza busca acelerar el desarrollo de arquitecturas de IA resilientes y listas para producción.

En una línea similar, Red Hat comentó cómo su colaboración ampliada con AMD ha dado frutos en la creación de entornos de IA productivos. Destacaron en particular el uso de GPUs Instinct en Red Hat OpenShift AI, que permite desplegar procesamiento de IA potente y eficiente en entornos híbridos de nube.

UALink: el nuevo estándar de interconexión abierta

Finalmente, empresas como Astera Labs y Marvell subieron al escenario para hablar sobre UALink, el nuevo ecosistema abierto de interconexión. Astera Labs destacó que este estándar está acelerando la innovación y ofreciendo más valor a los clientes, además de anunciar su plan para ofrecer un portafolio completo de productos UALink para respaldar las futuras infraestructuras de IA.

Marvell, por su parte, se unió a AMD para presentar el roadmap del switch UALink, que promete convertirse en la primera solución verdaderamente abierta de interconexión, habilitando una flexibilidad sin precedentes para los centros de datos de IA.